.png)

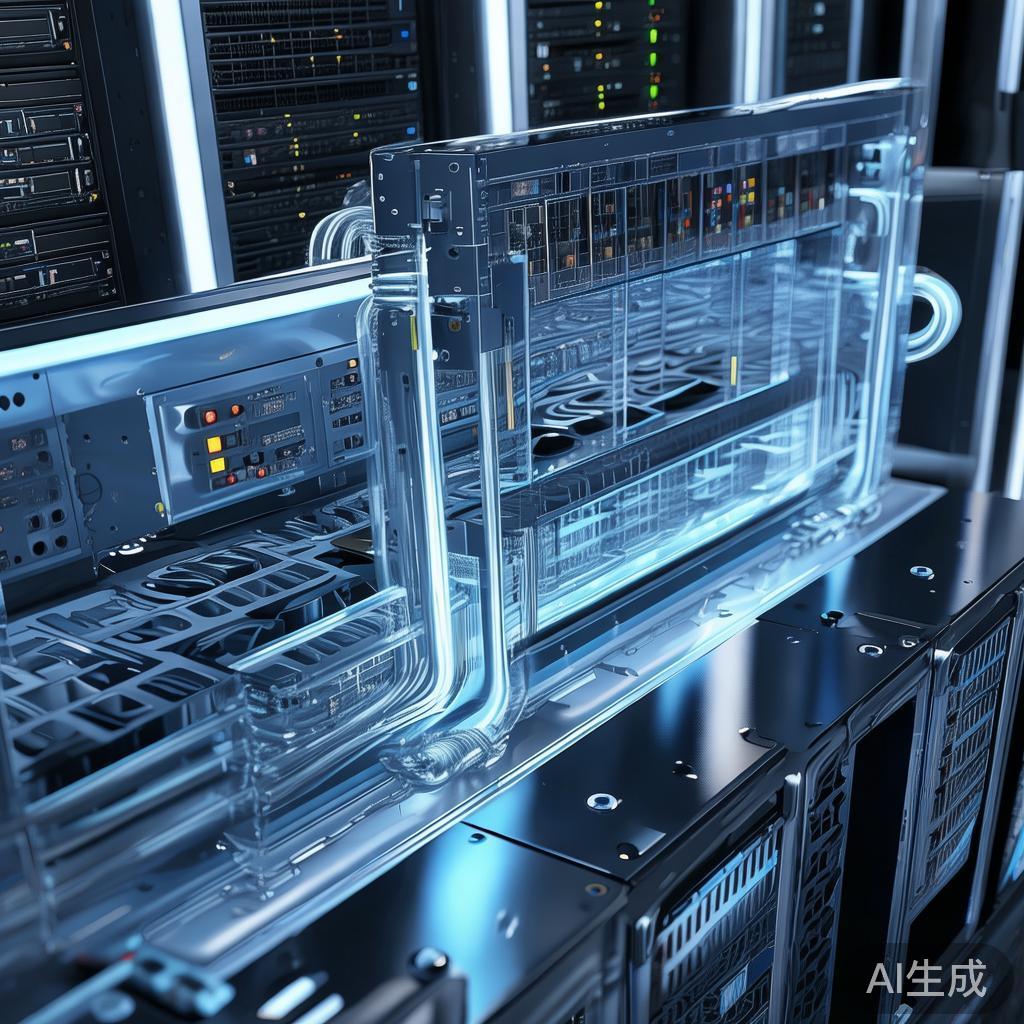

AI服务器散热与功耗如何兼顾?冷板液冷+高密度电源方案解析

- 优惠教程

- 12热度

随着AI大模型训练和推理需求激增,AI服务器的功耗与散热问题已成为制约算力部署的核心瓶颈。你是否也在为高密度GPU集群带来的散热难题而头疼?

为什么传统风冷已无法满足AI服务器需求?

我们曾长期依赖风冷系统,但面对现代AI芯片的功耗飙升,其局限性已暴露无遗。

- 散热效率下降:当单台服务器功耗超过20kW时,空气作为介质的热传导能力接近极限,难以有效带走热量

- 能耗占比过高:在传统数据中心中,冷却系统能耗可占总能耗的40%,风扇高速运转本身成为“隐形耗电大户”

- 局部热点频发:气流分布不均导致GPU、HBM等高功耗区域形成热点,芯片被迫降频以保安全

- 噪音与维护成本上升:高转速风扇不仅产生噪音,还易积尘堵塞风道,增加运维负担

以NVIDIA H100为例,其单卡TDP高达700W,若整机部署8卡GPU,仅GPU部分功耗就接近6kW,传统风冷已难以为继。

液冷为何成为AI服务器散热主流方向?

液体的比热容是空气的4倍以上,导热效率高出两个数量级。这意味着同样体积下,液冷能带走更多热量。

| 散热方式 | 适用功率密度 | PUE表现 | 部署复杂度 | 维护成本 |

|---|---|---|---|---|

| 传统风冷 | <15kW/机柜 | 1.4-1.8 | 低 | 低 |

| 增强型风冷 | 15-25kW/机柜 | 1.3-1.5 | 中 | 中 |

| 冷板式液冷 | 25-100kW/机柜 | 1.1-1.2 | 中高 | 中 |

| 浸没式液冷 | >100kW/机柜 | 1.05-1.1 | 高 | 高 |

从上表可见,冷板式液冷在散热能力、能效比和可维护性之间取得了最佳平衡,正成为当前AI服务器部署的首选方案。

冷板式液冷:当前最成熟的AI服务器散热方案

冷板式液冷通过金属冷板直接贴合CPU、GPU等发热芯片,冷却液在密闭管道内循环吸热,实现高效导出。

- 兼容性强:无需改造机房基础设施,可在现有数据中心逐步部署

- 安全性高:冷却液不接触电子元件,避免漏液风险

- 维护便捷:支持热插拔,便于故障排查与部件更换

- 成本可控:相比浸没式液冷,初期投入更低,ROI周期更短

亚马逊云科技已在其Graviton3和Trainium芯片服务器中采用定制化冷板液冷方案,实现单机柜功率密度提升至50kW以上。这种闭环系统使用专用冷却液循环,不消耗水资源,符合绿色数据中心趋势。

如果你正在考虑部署AI服务器集群,点击领取腾讯云AI服务器优惠,其部分高配机型已支持液冷选配方案。

功耗优化:从电源架构到芯片级设计

散热只是表象,功耗控制才是根本。我们需要从多个层面协同优化。

1. 高效电源设计降低配电损耗

传统服务器电源转换效率普遍在90%左右,意味着每10kW功耗就有1kW转化为热量。采用数字控制的高效电源模块(如MPS方案),可将效率提升至96%以上。

- 使用多相VRM设计,降低电流纹波,提升动态响应

- 采用GaN/SiC功率器件,减少开关损耗

- 集成智能调压技术,根据负载动态调整供电电压

2. 芯片级散热技术创新

台积电推出的3DVC(三维均热板)技术,将微通道冷却结构直接集成在芯片封装内部,极大缩短热传导路径。

- 3D堆叠均热板:在芯片与封装基板之间嵌入微流道,冷却液直接吸收热点热量

- 微泵循环系统:小型化泵体集成于服务器内部,实现冷却液自主循环

- 智能温控算法:基于传感器反馈动态调节流量,避免过度冷却造成能源浪费

这类技术虽尚未大规模商用,但预示了未来AI芯片散热的发展方向。

3. 系统级功耗管理策略

单纯追求峰值性能已不可持续,需引入精细化功耗控制机制。

- 动态频率调节(DVFS):根据任务负载实时调整GPU频率与电压

- 任务调度优化:避免多个高功耗任务同时运行,平滑功率曲线

- 冷热通道隔离:优化机柜布局,防止热气回流影响散热效率

- PUE监控与告警:实时监测能效指标,及时发现异常能耗

阿里云推出的AI加速实例系列,内置智能功耗管理系统,可根据业务负载自动调节算力输出。现在点击购买可享限时折扣,适合需要弹性算力的企业用户。

如何选择适合你的AI服务器散热方案?

并非所有场景都需要液冷。我们建议根据实际部署规模和预算做出决策。

| 应用场景 | 推荐散热方案 | 典型配置 | 成本参考 |

|---|---|---|---|

| 单台AI开发机 | 增强型风冷 | 4卡GPU,风道优化机箱 | 中等 |

| 中小规模训练集群(<10节点) | 冷板式液冷 | 双路CPU + 8卡GPU,液冷头预装 | 较高 |

| 大型推理平台(>50节点) | 冷板/浸没混合部署 | 高密度机柜,集中冷源系统 | 高 |

华为云近期推出新一代AI计算集群,支持冷板液冷与智能电源管理联动。其能效表现优于行业平均水平15%以上。点击了解详情并申请试用,获取专属配置建议。

未来趋势:液冷将成为AI服务器标配

据Vertiv预测,到2029年,单个AI GPU机柜功率将突破1MW。届时,风冷将彻底退出高性能AI计算领域。

- 标准化进程加速:OCP、ODCC等组织正在推动液冷接口标准化,降低部署门槛

- 运维自动化:AI驱动的冷却系统将实现流量、温度、压力的自适应调节

- 绿色节能导向:PUE限制趋严,液冷带来的能效优势将转化为运营成本优势

现在布局液冷,不仅是解决当下散热难题,更是为未来算力升级预留空间。

常见问题解答(FAQ)

| Q: 冷板式液冷会增加漏液风险吗? | A: 正规厂商采用全封闭金属管道与多重密封设计,漏液概率极低,且通常配备泄漏检测与自动切断机制。 |

| Q: 液冷服务器是否需要改造机房? | A: 冷板式液冷只需接入冷源分配单元(CDU),多数现代数据中心均可支持;浸没式则需专门机柜与管道系统。 |

| Q: 液冷方案的投资回报周期多长? | A: 在高密度部署场景下(>30kW/柜),通常2-3年可通过电费节省收回增量成本。 |

| Q: 是否所有AI服务器都必须用液冷? | A: 对于单机或小规模部署,增强型风冷仍具性价比优势;液冷更适合大规模、高密度集群。 |

| Q: 如何评估液冷系统的可靠性? | A: 关注厂商提供的MTBF(平均无故障时间)、压力测试报告及实际客户案例,优先选择通过OCP认证的产品。 |

以上文章内容为AI辅助生成,仅供参考,需辨别文章内容信息真实有效

温馨提示:云服务商优惠信息实时变动,本文内容仅供参考,最终价格请以官方活动页面最新公示为准。